前言

时间过得真快,2022年横空杀出个OpenAI,从ChatGPT开始,生成式AI行业的发展就开启了快车道时代,从一开始的ChatGPT“一家独大”到现在风靡全球的国产大模型DeepSeek、Qwen等的“百家争鸣”。AI的快速发展无疑会给生产生活带来巨大的革新,到目前AI+的融合已经在各种垂直领域遍地开花,使用AI的门槛越来越低,这就注定着计算机行业的人才需求已经将AI生产规定为必备技能。那么问题来了,既然各大AI公司已经提供了更有性价比的云服务,为什么还要自己折腾本地大模型呢?其实说到底还是数据安全问题,在实际的开发生产环境,公司数据具有极高的保密要求,因此在资源充裕的情况下本地部署大模型就成为了最佳选项。下面我们就简单说说如何在自己的电脑上部署本地的AI大模型吧。😀

一、下载安装Ollama

在Ollama发布之前,部署本地大模型是个“技术活”,对操作人员有着较高的专业要求,但Ollama的出现改变了这一局面,尽管目前的Ollama主要操作还是通过CMD(命令提示符)实现,但指令实在说不上复杂,只需要知道几个简单的指令基本就可以畅玩了。🧐

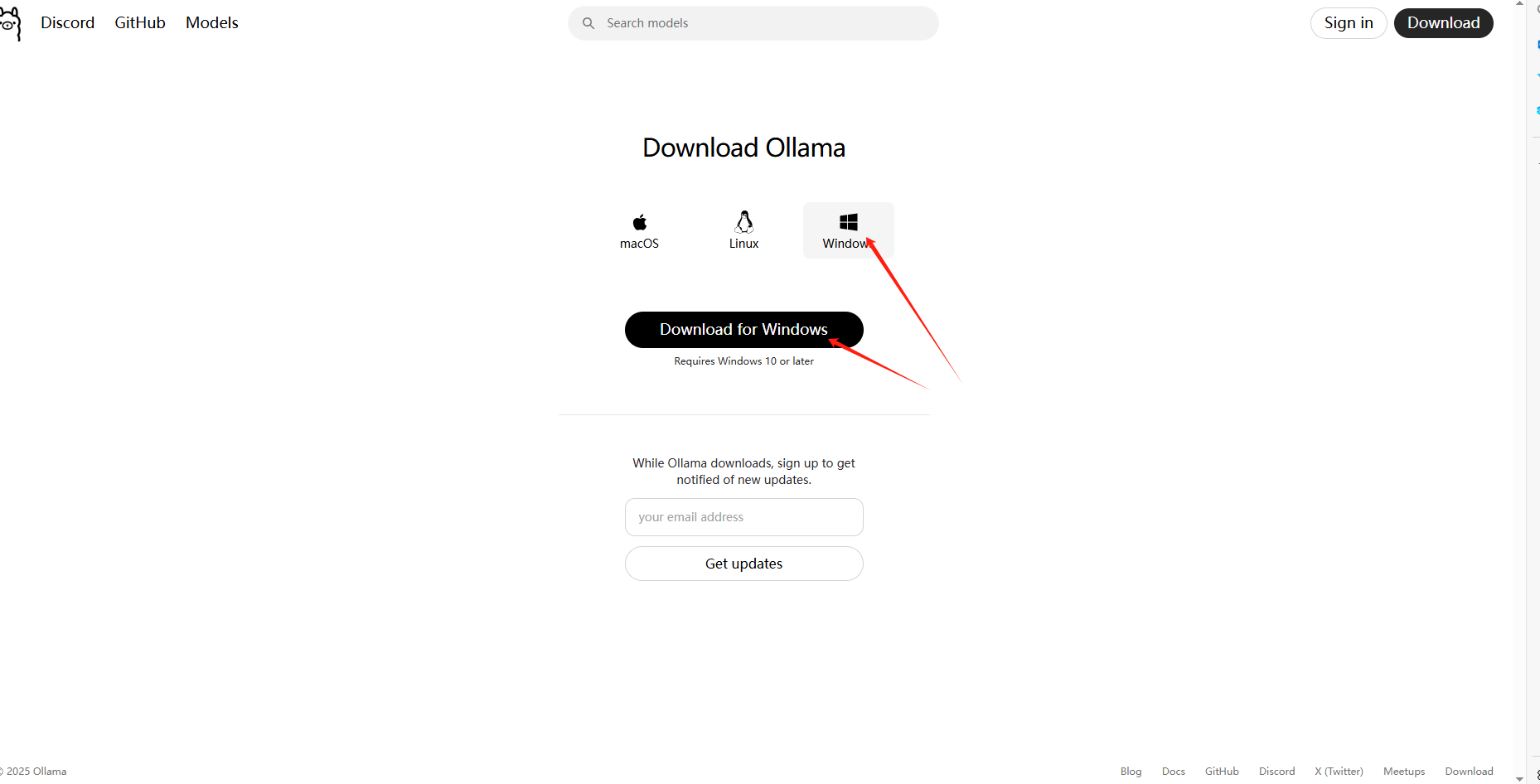

1.1 下载安装器

废话不多说,我们先来到Olllama的官网https://ollama.com/ 点击首页中间的黑色按钮“Download”就会跳转到下载页面,选择好对应版本后点击下载你就会发现网页一直在转圈(因为是通过github的域名githubusercontent下载的,这里推荐直接开科学上网)如果没法搞定也可以直接在微信公众号“NianSir年先生”私信我发你也行。🤗

这里提前说一句,如果你的电脑只有一个C盘或者说你C盘空间贼大完全不担心C盘“爆满”那就可以忽略下面自定义安装问题,直接从2.2部分开始看就好啦!😀

1.2 自定义安装目录

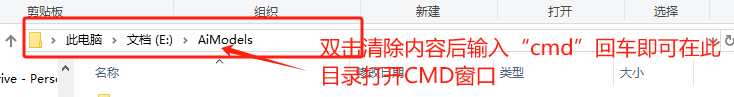

下载好了后肯定就是安装了,这里你直接运行下载好的exe文件会发现没有自定义安装选项,默认安装在C盘,但是如果你的C盘空间不足想安装在其他盘怎么办?还是通过CMD实现,可以先在你要安装的位置创建一个文件夹(还是老规矩路径不要用中文跟空格以防出现各种奇葩错误),例如我安装在 E:\AiModels 下,那我就把刚刚下载的安装器移动到AiModels这个文件夹里,再在这个文件夹打开CMD(在路径地址栏输入cmd回车即可)

然后在CMD中输入 OllamaSetup.exe /DIR=E:\AiModels 后回车,然后一直点下一步等安装完就行,你会发现安装路径已经变成了你指定的路径。接下来就是安装你要的大模型了。

二、通过Ollama安装AI本地大模型

安装好Ollama后当然就是安装你要的大模型啦~😁

2.1 自定义模型安装路径

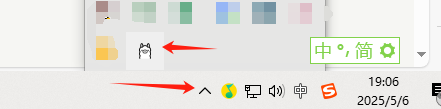

现在还有个问题就是Ollama也会将大模型安装在C盘,要知道大模型动辄几G几十G,很容易让C盘“爆满”,因此将大模型下载在别的位置也很重要,这里我就将大模型安装在 E:\AiModels\models 这个目录中,首先我们创建这个models目录,再在系统的环境变量(打开系统设置找到“关于”里面应该有个“高级系统设置”的链接,打开后点击“环境变量”再在“系统变量”中添加,具体步骤不截图了,配置环境变量网上教程很多大伙不明白随便一搜就知道啦~)注意不是“用户变量”是在下面的“系统变量”中添加一个系统变量,名称是 OLLAMA_MODELS ,值填写你要指定的大模型安装位置例如我的 E:\AiModels\models然后保存。

好了现在是最重要的一步!!!退出一下Ollama(系统状态栏找到Ollama的图标右键退出就好了)或者直接在任务管理器里结束Ollama

然后再在CMD中运行 ollama --vsrsion 如果正常输出了ollama的版本号那就OK。这里退出的左右是让Ollama刷新设置,变更模型安装目录到你指定的目录,如果不退出一下的话直接下模型还是在C盘。

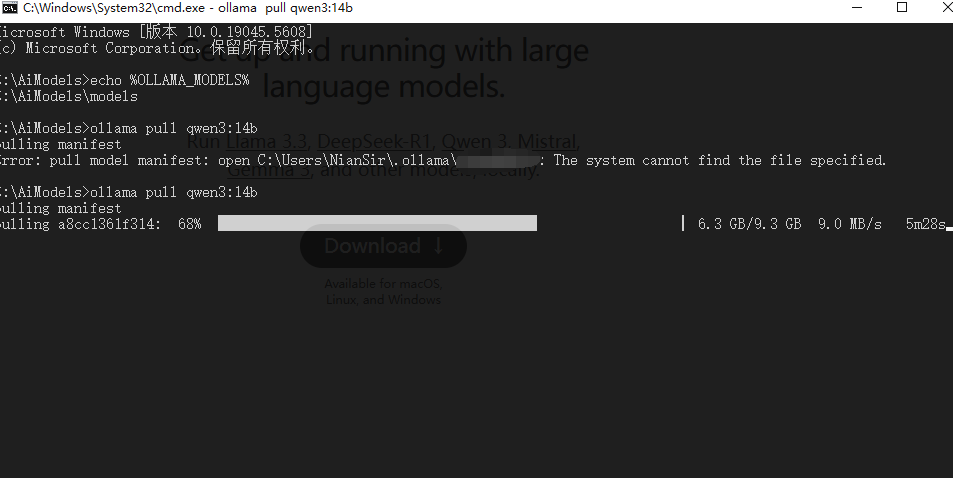

2.2 pull你要下载的大模型

搞定模型下载路径后,现在就是拉取大模型镜像了,注意本地安装大模型对电脑硬件是有一定要求的,要根据你的电脑配置(主要是显卡和显存、CPU、内存)选择合适的参数量模型,具体选择你可以直接问一下AI工具,告诉它你的电脑配置让它给你推荐一个合适参数量的模型。

比如我的电脑是RTX2060S 12GB显存,内存也有16GB以上,所以我选择了qwen3:14b(这个多少b就是指参数量有多少亿,越多效果越好相应性能要求越高,一般的游戏本啥的选7-14b差不多了)具体还是直接丢AI问一下比较好以防电脑带不动。

以Qwen3-14B模型为例,在CMD输入一下指令拉取模型(下载):

ollama pull qwen3:14b这里下载速度跟网络有关,一般不需要科学上网,下载可能较慢,如果下载进度卡住可以过段时间在CMD内按下回车刷新进度条

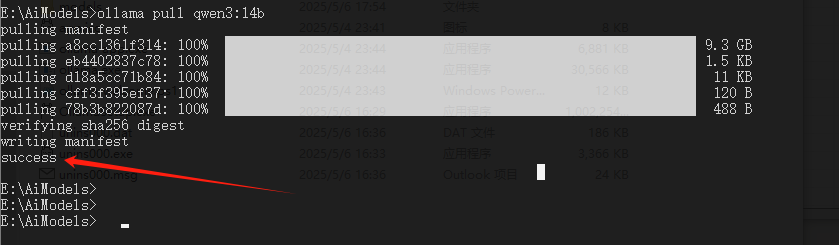

等待下载完成后CMD中出现下面的提示就是安装成功啦:

三、体验本地大模型

安装好了当然要跑一手玩玩看啦!通过下面的指令使用指定模型对话:

#单次对话

ollama run qwen3:14b "用Python实现快速排序算法"

#连续对话

ollama run qwen3:14b下面是RTX 2060S 12GB运行的效果展示(正常1倍速),可以看到速度还是可以的。当然比官方肯定慢一些毕竟本机性能上限摆在这里。

玩够了关闭大模型?直接叉掉这个CMD就行啦~关闭大模型服务后Ollama退不退出都无所谓的,不会占用多少资源。

好啦,现在你就可以在本地愉快的“调教”你的专属大模型咯,是不是很简单?那就快去试试吧~😋

常见问题QA

1Q:pull的时候前面下载挺快的后面直接变100Kb了贼慢咋办?

1A:间歇性下载即可,可以通过脚本或者定时任务实现,最简单的办法就是变很慢后直接ctrl+c停止下载,过几秒再执行一次pull后面就能接上下载了而且速度会很快。

2Q:我不想在CMD里面提问咋办?有没有对接其他AI工具的办法?

2A:有的兄弟,有的。推荐Chatbox,教程在这:https://chatboxai.app/zh/help-center/connect-chatbox-remote-ollama-service-guide 配置很简单,其他AI工具也是类似了查阅他们官方文档就好。

3Q:?

3A:不用栓Q了,还有问题直接博客留言或者公众号私信我看到了就会马上回啦!😆

评论 (0)